AIやコンピュータって、もう人間よりずっと賢くて速いイメージ、ありますよね?

確かに計算処理能力だけで言えば、人間の脳なんて目じゃない部分が多々あります。

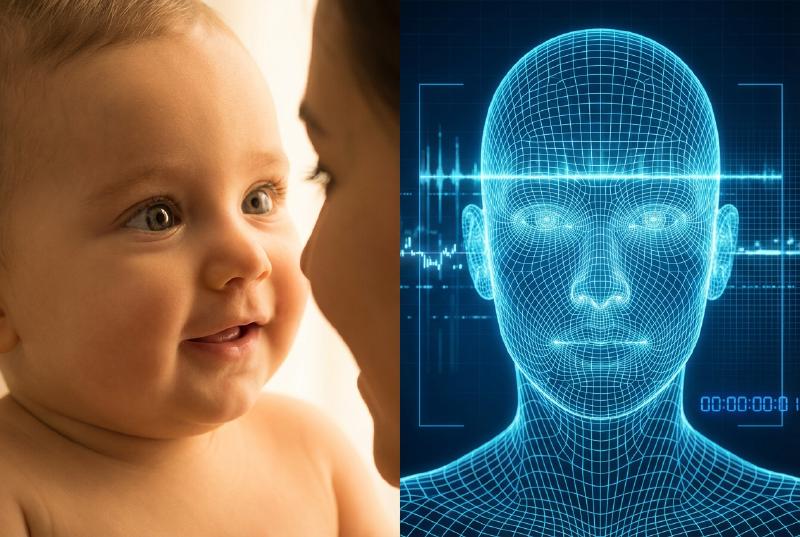

でも、こと「認識する能力」においては、まだ人間の赤子に及ばない部分があるってご存知ですか?

例えば 「人の顔」を認識する速度と精度 です。この違い、一体どこから生まれるんでしょうか。

処理能力ではなく「仕組み」の違い

人間がパッと人を見て、「あ、鈴木さんだ」と認識するまでの時間。

一方で、コンピュータがカメラから画像を取り込み、「これは人の顔で、鈴木さんである可能性が99%」と認識するまでの時間。

実は、内部的な電気信号の伝達速度だけで比べれば、現代のコンピュータは人間と遜色ない、ヘタしたらそれ以上のレベルにあるはずなんです。

ニューラルリンクとか、人間の神経回路を模した技術もどんどん進化していますしね。

では、なぜそこに「差」が生まれるのか?

私は、その決定的な違いは 「学習の深度」と「プロセスの複雑さ」 にあると考えています。

本能 vs プログラム

人間って、生まれた瞬間から……いや、胎児の頃からかもしれません。「人間」を認識し続けているんですよね。

「人間と動物は違う生き物だ」なんて理屈で理解する前に、本能レベルで人の顔を識別するようにプログラムされています。脳には「紡錘状回」という顔専用の処理領域があるとも言われていますし。

対してコンピュータは、それを後天的なプログラムとして一から学ばなきゃいけません。

ここに根本的なハンデがあります。

コンピュータにとって、「視覚(カメラ入力)」と「脳(処理)」は別々のハードウェアなんです。

- カメラから映像を入力する

- デジタルデータに変換する

- ノイズを除去し特徴量を抽出する

- 膨大なデータベースと照合する

- 「顔である」と判定する

このプロセスを回すのに、どうしても物理的な時間がかかります。

さらにコンピュータには、人間のように「なんとなく」で済ませることが許されません。

「数多ある情報から確実に正解をチョイスしなければならない」 という、失敗が許されない制約があるため、どうしても処理が慎重(=重く)なりがちなんですよね。

自動運転に見る「認識速度」の戦い

この認識速度の違いが、人の命に関わるレベルで重要になるのが 自動運転の分野 です。

最近の車にはLiDAR(レーザー)や高性能カメラが搭載されていて、人間や障害物を検知して自動でブレーキを踏んでくれますよね。

このシステム、基本的には「カメラが何かを検知し、解析し、危険と判断して、ブレーキを踏む」というプロセスを辿ります。

人間よりも「速く」なければ意味がない

ここで重要なのは、 「人間がブレーキを踏むよりも先に判断して踏まなければならない」 という絶対的なタイムリミットがあることです。

もしコンピュータの認識速度が人間より遅かったら、自動ブレーキなんてただの重りです(笑)。

だからこそ、自動運転システムは、人間の視覚認知よりも速く解析を済ませる必要があるわけです。

「え、コンピュータなんだから、人間より速くて当然でしょ?」

そう思うかもしれませんが、実際はそう簡単じゃないんですよね。

CPUの発熱や処理速度の限界もあるし、雨や逆光でカメラが見えにくい状況だってある。そんな悪条件下での映像解析は、AIにとっても超難問なんです。

だから、現在の自動運転技術では、単なる「映像解析(AIの目)」だけに頼るのを諦めつつあります。

その代わりに、 レーダー照射による物理的な障害物検知 や、速度と距離の計算による 「衝突確率」の算出 といった、複数のロジックを総動員しているんです。

「現在速度がこれだけ出ているなら、停止までの距離はこれくらい必要だ。だから、この距離に何かある時点で即ブレーキ!」

こういう、ある種「ズル」とも言える物理演算を組み合わせることで、人間の反射速度に対抗しているわけです。

まとめ:AIは「視覚」以外で私たちを守る

この極限の状況下で、人間とコンピュータどちらがより正解に近い判断を下せるか。

それはまだ、時と場合によるでしょう。

でも、この 「人間を超えるために、視覚以外のセンサーや計算処理を総動員して挑む姿」 こそが、人工知能(AI)らしい進化の形なんじゃないかな、と私は感じています。

人間と同じ土俵(視覚認識)だけで戦わなくたっていい。

使える武器は全部使って、結果として人間を守ってくれるなら、それが最強のパートナーですよね。

皆さんは、いつかコンピュータが「人間の顔」を人間以上に瞬時に理解する日が来ると思いますか?

私は、そう遠くない未来に来る気がしています。

それでは。